DeepSeek R1 모델은 인공 지능 산업에 큰 영향을 미쳤으며 TATGPT를 능가하고 미국 App Store의 주요 위치를 차지했습니다. 그러나 중국의 데이터 스토리지와 관련된 개인 정보에 대한 우려로 인해 많은 사용자가 로컬 배치 옵션을 찾도록했습니다. 다행히 LM Studio, Ollama 및 Open WebUI를 사용하여 Android 및 iPhone에서도 Windows, MacOS 또는 PC Linux에서 DeepSeek R1을 로컬로 운영 할 수 있습니다. STEP -BY -STEP 지침은이 프로세스를 수행하는 데 도움이됩니다.

시스템에 DeepSeek R1을 로컬로 실행하도록 요청하십시오.

시작하기 전에 장치가 다음을 포함하여 최소 요구 사항을 충족하는지 확인하십시오.

– PC, Mac 또는 Linux : 8GB 이상의 RAM이 권장됩니다.

– Android 및 iPhone : 원활한 작동에는 6GB 이상의 RAM이 필요합니다.

LM Studio와 함께 PC에서 DeepSeek R1 로컬을 실행하는 방법 :

1. 시스템에서 LM Studio (버전 0.3.8 이상)를 다운로드하여 설치하십시오.

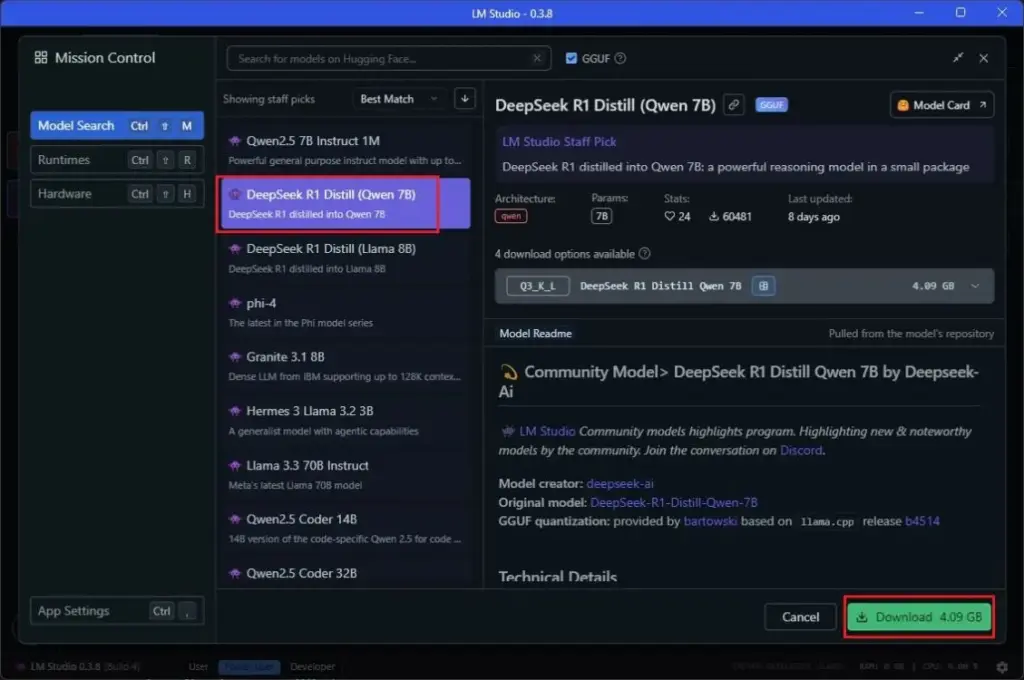

2. LM Studio를 시작하고 DeepSeek R1 모델 (Qwen 7B)을 검색하십시오.

3. 모델을 다운로드하십시오 (5GB 이상의 스토리지와 8GB RAM이 필요함).

4. 대화 창으로 전환하고 모델을 다운로드하십시오.

5. “로드 모델”을 클릭하십시오. 오류가 발생하면 GPU로드를 0으로 줄이고 다시 시도하십시오.

6. 이제 컴퓨터에서 DeepSeek R1과 로컬로 대화 할 수 있습니다.

Ollama와 함께 PC에서 현지에서 DeepSeek R1을 실행하는 방법 :

1. Windows, MacOS 또는 Linux에 Ollama (무료)를 설치하십시오.

2. 명령을 실행하여 DeepSeek R1 1.5B 모델을 다운로드하십시오.

3. 고성능 PC가있는 경우 7B 모델을 실행해보십시오.

4. 현지에서 DeepSeek R1과 채팅을 시작하십시오.

Open Webui를 사용하여 DeepSeek R1 로컬을 실행하는 방법 :

1. 컴퓨터에 Python과 Pip을 설정하십시오.

2. webui 설치.

3. Ollama를 통해 Deepseek R1 모델을 시작하십시오.

4. Ollama를 실행 한 후 Webui를 열기 시작했습니다.

5. 열기 http : // localhost : 8080 브라우저에서 DeepSeek R1과 채팅을 시작하십시오.

Android & iPhone에서 현지에서 DeepSeek R1을 실행하는 방법 :

1. PocketPal AI를 POKETPAL AI (Android) 또는 App Store (iPhone)를 설치하십시오.

2. 응용 프로그램을 열고 모델로 이동하십시오.

3. DeepSeek R1 모델을 다운로드하고 휴대 전화의 모델과 채팅을 시작하십시오.

이 방법을 사용하면 인터넷 연결없이 장치에서 DeepSeek R1을 로컬로 실행하여 개인 정보를 향상시킬 수 있습니다. 온라인 서버에 기대지 않고 인공 지능에 대한 대화를 즐길 수 있습니다! 🚀

그만큼 Deepseek R1 이 모델은 AI 산업에 큰 영향을 미쳤으며 TATGPT를 능가하고 미국 앱 스토어의 선두 자리를 보장했습니다. 그러나 DeepSeek R1은 공식 웹 사이트에서 무료로 액세스 할 수 있지만 중국의 데이터 저장과 관련된 개인 정보에 대한 우려로 인해 많은 사용자가 옵션을 검색했습니다. 다행히도, 당신은 지역에서 Deepseek R1을 실행할 수 있습니다 Windows, MacOS 또는 PC Linux~처럼 안드로이드와 아이폰 장비, 사용 LM Studio, Ollama 및 Open Webui. 이 단계 -BY -Step 안내서는 전체 프로세스를 안내합니다.

DeepSeek R1을 로컬로 실행하기위한 시스템 요구 사항

시작하기 전에 장치가 최소 요구 사항을 충족하는지 확인하십시오.

- PC, Mac 또는 Linux: 적어도 8GB RAM 추천. 8GB의 메모리를 사용하면 실행할 수 있습니다 Deepseek R1 1.5b 대략 모델 13 초당 알림 코드. 고급 모델 (7b, 14b, 32b 및 70b)이 필요합니다 RAM, 빠른 CPU 및 High -End GPU를 추가하십시오.

- Android & iPhone: 적어도 6GB RAM 원활한 작동에 필요합니다. 고급 장비 Snapdragon 8 시리즈 또는 Apple의 시리즈 칩 더 잘할 것입니다.

LM Studio를 사용하여 PC에서 현지에서 DeepSeek R1을 실행하는 방법

LM Studio는 로컬 AI 모델의 실행을 단순화하는 사용자 친화적 인 도구입니다. 이것은 사용하는 방법입니다.

- LM Studio를 다운로드하여 설치하십시오 PC, Mac 또는 Linux 시스템의 (버전 0.3.8 이상).

- LM 스튜디오를 시작하십시오 왼쪽 제어판의 검색 창으로 이동하십시오.

- 아래에 모델 검색찾다 Deepseek R1 Depek R1 (Qwen 7B) (위의 가능 껴안다).

- 모델을 다운로드하십시오 (적어도 요청하십시오 5GB 스토리지 및 8GB RAM).

- 전환하다 채팅 창과 다운로드 모델.

- 딸깍 하는 소리 “로드 모델”. 오류가 있으면 GPU로드를 0으로 줄입니다 그리고 다시 시도하십시오.

- 이제 할 수 있습니다 DeepSeek R1과 로컬로 채팅하십시오 컴퓨터에서!

Ollama와 함께 PC에서 현지에서 Deepseek R1을 실행하는 방법

Ollama는 AI 모델을 효과적으로 실행하기위한 명령 줄 인터페이스를 제공합니다.

- Windows, MacOS 또는 Linux에 Ollama (무료)를 설치하십시오.

- 열려 있는 터미널 (또는 명령 프롬프트) 다음 명령을 실행하여 다운로드하십시오 DeepSeek R1 1.5B 모델:

ollama run deepseek-r1:1.5b

- 고성능 PC가 있다면 실행을 시도하십시오 모델 7b그 요구 사항 4.7GB 메모리:

ollama run deepseek-r1:7b

- 채팅을 시작하십시오 현지에서 Deepseek R1을 사용합니다.

- 세션을 제거하려면 사용하십시오 ctrl + d 지름길.

Open WebUI를 사용하여 DeepSeek R1 로컬을 실행하는 방법

a 인터페이스는 교회와 같습니다Ollama와 통합 된 Open Webui를 설치할 수 있습니다.

- 파이썬과 핍을 설정하십시오 컴퓨터에서.

- 열려 있는 터미널 (또는 명령 프롬프트) 및 webui 오프닝 설정 :

- Ollama를 통해 DeepSeek R1 모델을 시작하십시오.

ollama run deepseek-r1:1.5b

- Ollama를 실행 한 후 Webui를 열기 시작합니다.

- 열려 있는 http : // localhost : 8080 브라우저에서.

- 딸깍 하는 소리 “시작하다” 그리고 당신의 이름을 입력하십시오.

- Open WebUI는 자동으로 감지됩니다 Deepseek R1 기본 모델입니다.

- 중지, 마우스 오른쪽 버튼을 클릭하십시오 시스템 트레이의 Ollama 신청서를 종료하십시오.

Android & iPhone에서 현지에서 DeepSeek R1을 실행하는 방법

모바일 장치에서 DeepSeek R1을 로컬로 운영하려면 포켓 팔 ai 최선의 선택입니다.

- PocketPal AI를 설치하십시오 Play Store (Android) 또는 App Store (iPhone)에서.

- 응용 프로그램을 열고 누릅니다 “모델로 이동”.

- 딸깍 하는 소리 버튼 ++ 오른쪽 하단에서 선택되었습니다 “포옹 얼굴에서 추가”.

- 찾다 Deepseek-R1-Distill-Qwen-Qwen-1.5b ~을 통해 바토프 스키.

- 적절한 다운로드 양자화 모델 사용 가능한 RAM을 기준으로Q5_K_M 요구 사항 ~ 1.3GB RAM).

- 뒤로 그리고 누르십시오 “짐” 현지에서 DeepSeek R1과 채팅을 시작합니다.

- 이제 Android 또는 iPhone 전화의 DeepSeek R1 모델로 로컬에서 대화 할 수 있습니다.

마지막 생각

이 방법을 사용하면 실행할 수 있습니다 현지에서 Deepseek R1 당신의 UPS PC, Mac, Linux, Android 또는 iPhone 인터넷 연결이 없음, 보증 더 나은 프라이버시. 하는 동안 모델 1.5b 및 7b 환각을 만들거나 잘못 만들 수 있습니다. 모델 32B 기부 더 나은 암호화와 추론 당신이 있다면 가능성 강력한 하드웨어.

이제 당신은 즐길 수 있습니다 AI 대화 온라인 서버에 의존 할 필요가 없습니다! 🚀

<

div class = “임신”>

<

H1> 결론 LM Studio, Ollama 및 Open WebUI를 사용하여 Windows, MacOS, Android 및 iPhone에서 로컬에서 Deepseek R1을 실행할 수 있습니다. 이를 통해 인터넷을 연결하지 않고 대화를 경험하여 더 나은 개인 정보를 보장 할 수 있습니다. 장치에서 AI에서 대화를 경험하려면 위의 단계를 시도하십시오! 🚀